Cientistas quebram barreira de um bilhão de partículas, usando deep learning para simular nossa galáxia com detalhes sem precedentes, abrindo uma nova era na astrofísica.

Introdução

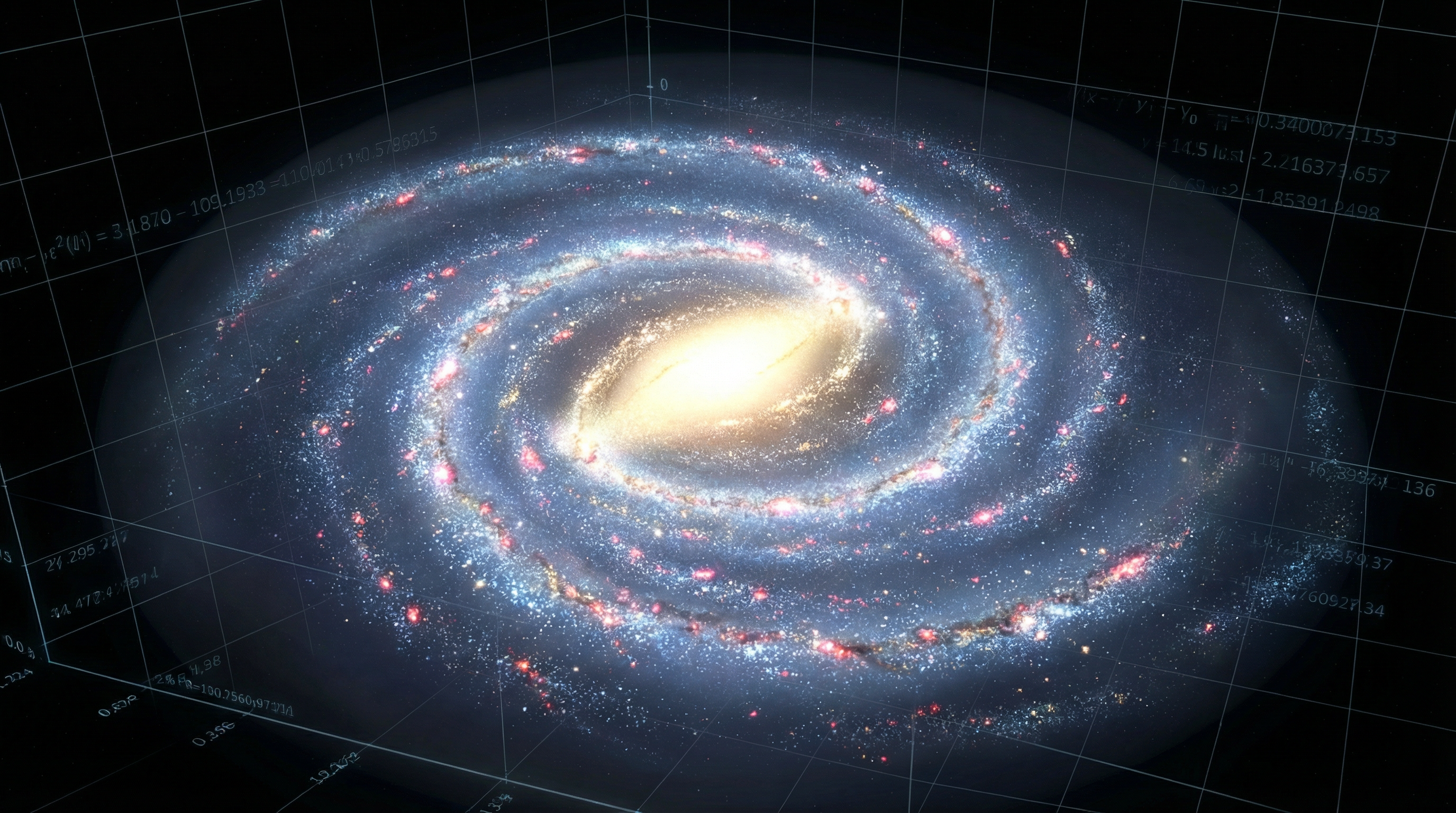

A vastidão do cosmos sempre representou um desafio monumental para a ciência. Compreender a intrincada dança de bilhões de estrelas, gás e matéria escura que compõem nossa própria galáxia, a Via Láctea, tem sido uma busca incessante. As simulações computacionais são a nossa principal ferramenta para desvendar os segredos da evolução galáctica, mas sempre esbarraram em uma barreira formidável: a escala. Fenômenos cruciais, como as explosões de supernovas, ocorrem em escalas minúsculas e em frações de segundo, enquanto a galáxia evolui ao longo de bilhões de anos. Conciliar essas escalas díspares em uma única simulação era, até agora, computacionalmente proibitivo. No entanto, uma equipe internacional de pesquisadores, liderada por Keiya Hirashima do RIKEN, acaba de anunciar um avanço que redefine os limites da astrofísica computacional. Em um estudo a ser apresentado na conferência SC25, eles revelam a primeira simulação da Via Láctea que acompanha a evolução de cada estrela individualmente, um feito alcançado através de uma combinação inovadora de simulações hidrodinâmicas tradicionais e um modelo substituto baseado em inteligência artificial. Esta nova abordagem não apenas quebrou a barreira de um bilhão de partículas, mas o fez com uma eficiência mais de 100 vezes superior aos métodos anteriores, prometendo desvendar os mistérios da formação estelar e da evolução química da nossa galáxia com uma fidelidade nunca antes imaginada. Este marco representa um salto quântico, transformando o que era ficção científica em realidade científica e abrindo um novo e excitante capítulo na exploração do nosso universo.

O Universo em um Supercomputador: O Desafio das Escalas Cósmicas

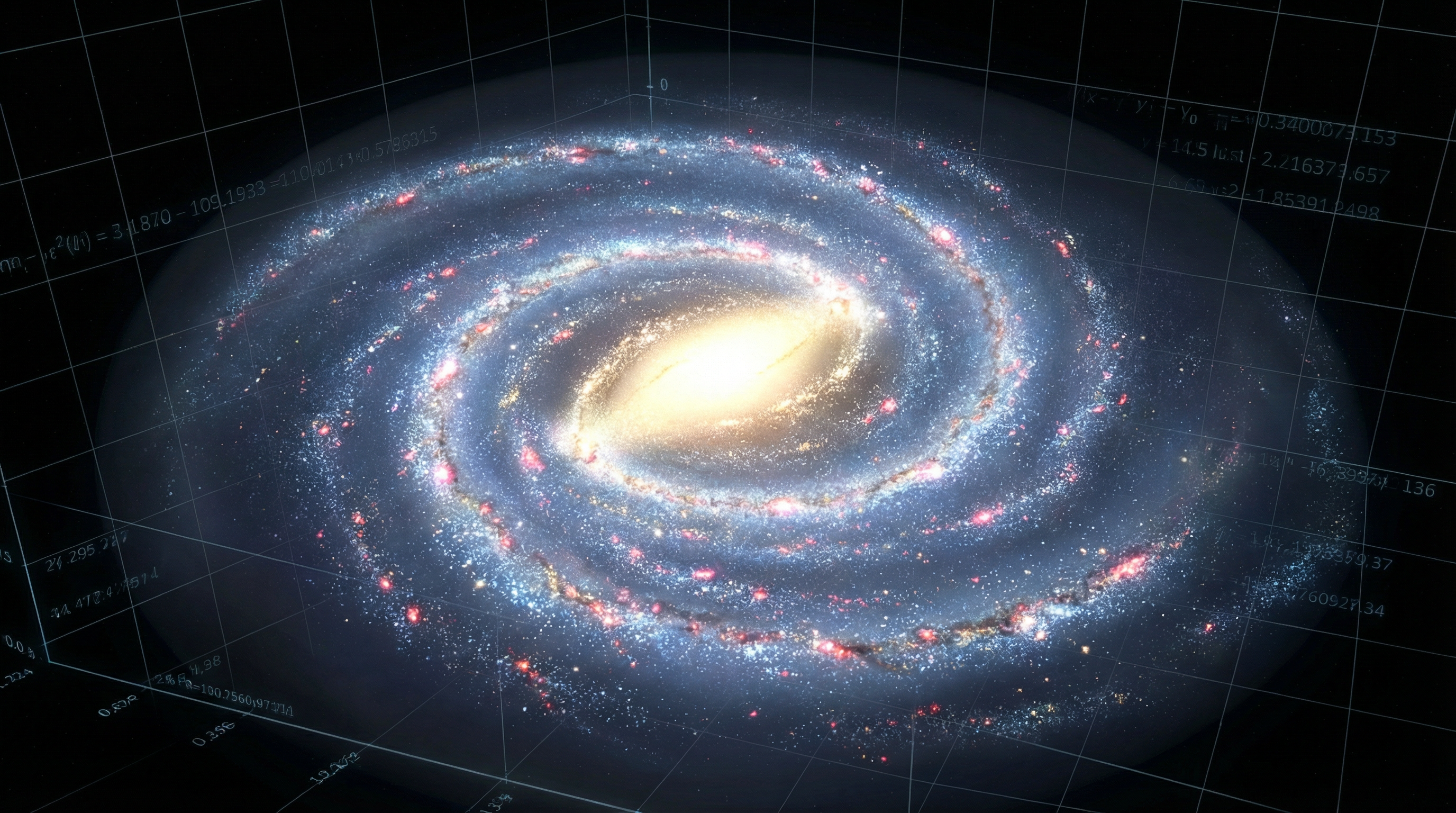

Para entender a magnitude da recente descoberta, é crucial mergulhar nos desafios que os astrofísicos enfrentam ao tentar modelar uma galáxia como a nossa. A Via Láctea é um sistema complexo, um ecossistema cósmico onde a matéria é constantemente reciclada. A história do universo, desde o Big Bang, está escrita na composição química das estrelas. Os elementos primordiais, hidrogênio e hélio, formaram as primeiras estrelas. Dentro desses caldeirões nucleares, elementos mais pesados foram forjados e, no final de suas vidas, estrelas massivas explodiram como supernovas, espalhando esses novos elementos pelo espaço. Esse material enriquecido, contendo carbono, oxigênio e ferro, mistura-se com o gás interestelar, tornando-se o berço de novas gerações de estrelas e planetas – incluindo o nosso. Este ciclo de nascimento, morte e renascimento estelar tem se repetido por mais de 10 bilhões de anos.

Simular este processo é uma tarefa hercúlea devido à disparidade de escalas. A Via Láctea, com seu halo de matéria escura, estende-se por centenas de milhares de anos-luz. Em contraste, a explosão de uma supernova, um evento que injeta energia e elementos pesados no meio interestelar, ocorre em uma região de apenas alguns anos-luz e se desenrola em questão de anos. Os métodos de simulação tradicionais, como a hidrodinâmica de partículas suavizadas (SPH), precisam calcular as interações entre todas as partículas do sistema. Para capturar com precisão os efeitos de uma supernova, a simulação precisa usar passos de tempo extremamente curtos, da ordem de apenas 100 anos. No entanto, para simular a evolução da galáxia ao longo de milhões ou bilhões de anos, o número de cálculos se torna astronômico, excedendo a capacidade até mesmo dos supercomputadores mais poderosos do mundo. Este gargalo computacional, conhecido como a “barreira de um bilhão de partículas”, limitou severamente a resolução e o realismo das simulações galácticas. Os modelos anteriores eram forçados a usar “receitas” simplificadas, tratando grupos de estrelas como uma única partícula e aproximando os efeitos de feedback das supernovas, perdendo assim detalhes cruciais sobre a formação de estrelas individuais e a distribuição de elementos químicos.

A Solução Híbrida: Unindo Forças com a Inteligência Artificial

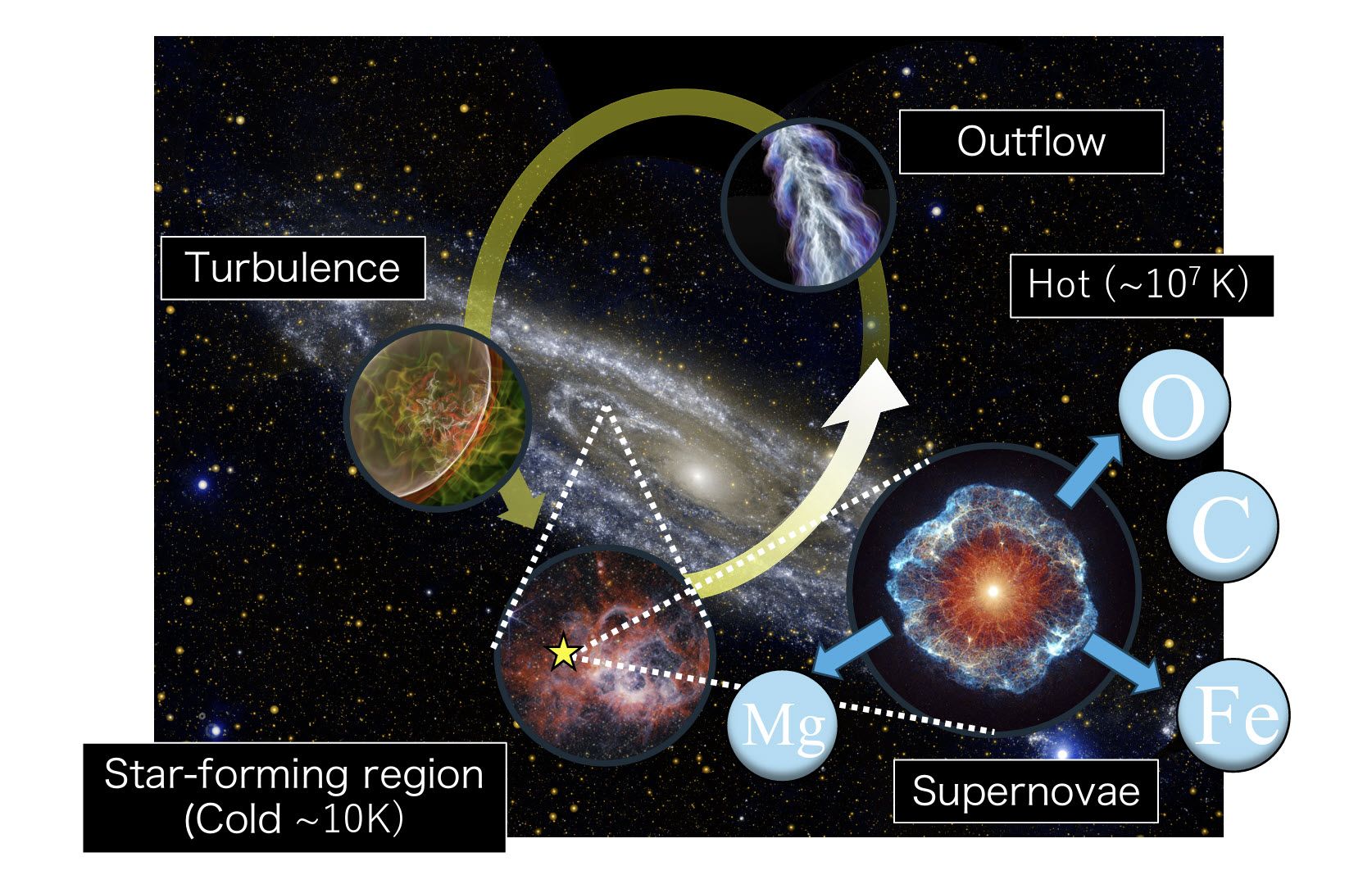

Para superar essa barreira intransponível, a equipe de Hirashima desenvolveu uma abordagem híbrida engenhosa, detalhada no artigo “The First Star-by-star N-body/Hydrodynamics Simulation of Our Galaxy Coupling with a Surrogate Model”. A inovação central reside em dividir o problema computacional em duas partes, gerenciadas por diferentes conjuntos de processadores (nós) dentro de um supercomputador. A grande maioria dos nós, chamados de “nós principais”, executa uma simulação N-body/SPH padrão da galáxia como um todo, usando um passo de tempo global relativamente longo, de cerca de 2.000 anos. Este passo de tempo é suficiente para capturar a evolução geral da galáxia, como o movimento orbital das estrelas e do gás.

No entanto, quando uma estrela massiva está prestes a explodir como uma supernova, a simulação entra em uma nova fase. Uma pequena região cúbica, com 60 parsecs de lado (cerca de 195 anos-luz), centrada na estrela em explosão, é isolada. As informações sobre todas as partículas dentro deste cubo – sua densidade, temperatura e velocidade – são enviadas para um conjunto separado e muito menor de processadores, os “nós de pool”. É aqui que a magia da inteligência artificial acontece. Em vez de realizar uma simulação hidrodinâmica detalhada e computacionalmente cara da explosão, os nós de pool utilizam um modelo substituto (surrogate model) de deep learning. Este modelo, baseado em uma arquitetura de rede neural convolucional 3D chamada U-Net, foi pré-treinado com os resultados de milhares de simulações de supernovas de alta resolução. Com base nas condições iniciais do cubo, a IA prevê com precisão como a explosão da supernova evoluirá e como ela afetará o gás circundante ao longo de um período de 0,1 milhão de anos. O resultado dessa previsão é então enviado de volta aos nós principais, que atualizam o estado das partículas na simulação global. Essencialmente, a IA atua como um “oráculo” que resolve a parte mais difícil e demorada do cálculo, permitindo que a simulação principal avance com seus grandes passos de tempo.

Para desenvolver e executar esta simulação complexa, os pesquisadores contaram com uma infraestrutura de software sofisticada. O Framework for Developing Particle Simulators (FDPS) foi usado para gerenciar a distribuição de partículas e as comunicações entre os milhões de núcleos de processamento. Além disso, eles criaram o Particle Interaction Kernel Generator (PIKG), uma ferramenta que gera automaticamente código otimizado para calcular as interações de partículas em diferentes arquiteturas de supercomputadores, incluindo o supercomputador Fugaku no Japão, onde a simulação principal foi executada. Esta combinação de hardware de ponta, software avançado e um algoritmo de IA inovador permitiu que a equipe realizasse a primeira simulação da Via Láctea com 49 bilhões de partículas, alcançando uma resolução onde cada partícula de gás e estrela tem uma massa inferior à do nosso Sol. Isso significa que, pela primeira vez, podemos ver a formação e a evolução de estrelas individuais dentro de uma simulação que abrange toda a galáxia.

Implicações Científicas: Uma Nova Janela para o Cosmos

As implicações deste avanço são profundas e de longo alcance, abrindo uma nova era para a astrofísica computacional. Ao simular a Via Láctea estrela por estrela, os cientistas podem agora investigar questões fundamentais que antes estavam fora de alcance. Uma das áreas mais promissoras é o estudo da “arqueologia galáctica”. As estrelas mais antigas da nossa galáxia contêm em suas atmosferas um registro fóssil da composição química do universo primordial. Ao comparar a distribuição de elementos químicos nas estrelas simuladas com as observações de estrelas reais na Via Láctea, os pesquisadores podem testar e refinar nossos modelos de evolução química galáctica, entendendo melhor como os elementos essenciais à vida, como o carbono e o oxigênio, foram produzidos e distribuídos ao longo do tempo.

A simulação também oferece uma visão sem precedentes sobre o ciclo de vida da matéria nas galáxias. Podemos agora seguir o percurso do gás desde o meio interestelar difuso até a formação de densas nuvens moleculares, o nascimento de novas estrelas dentro dessas nuvens e, finalmente, o retorno de matéria e energia para o meio interestelar através de ventos estelares e explosões de supernovas. Este nível de detalhe permite estudar a “meteorologia galáctica” – a turbulência e os fluxos de gás que regulam a taxa de formação estelar. Além disso, a capacidade de resolver estrelas individuais é crucial para entender a formação de estruturas estelares, como aglomerados abertos e associações estelares, e como eles se dissolvem e se misturam no disco galáctico.

A metodologia híbrida em si, que acopla simulações baseadas em primeiros princípios com modelos de inteligência artificial, representa uma nova paradigma que pode ser aplicado a uma vasta gama de problemas científicos. Qualquer campo que lide com fenômenos que abrangem múltiplas escalas, desde a ciência dos materiais até a climatologia, pode se beneficiar de abordagens semelhantes. No contexto da astrofísica, essa técnica poderia ser estendida para simular a formação de buracos negros supermassivos nos centros das galáxias ou a complexa interação entre galáxias em colisão. A portabilidade do código, que funciona eficientemente em diversas arquiteturas de supercomputadores, garante que esta nova ferramenta poderosa estará acessível à comunidade científica global, acelerando o ritmo das descobertas.

Conclusão: O Futuro da Simulação Astronômica

A simulação estrela por estrela da Via Láctea, realizada pela equipe de Keiya Hirashima, é mais do que apenas um feito técnico; é uma mudança de paradigma na forma como exploramos o universo. Ao unir o poder bruto dos supercomputadores com a inteligência preditiva da IA, os pesquisadores não apenas contornaram uma barreira computacional de longa data, mas também criaram uma ferramenta de descoberta com um potencial imenso. Com uma velocidade de cálculo mais de 100 vezes superior aos métodos de ponta anteriores, a capacidade de simular um milhão de anos da evolução da nossa galáxia em menos de três horas no supercomputador Fugaku abre a porta para a exploração de longos períodos da história cósmica com um nível de detalhe sem precedentes.

O futuro da astronomia computacional parece mais brilhante do que nunca. Nos próximos anos, podemos esperar que simulações ainda mais detalhadas e realistas nos ajudem a responder a algumas das perguntas mais profundas sobre nossas origens cósmicas. Como a Via Láctea se formou e evoluiu para a magnífica espiral que vemos hoje? Como as estrelas e os planetas se formam em meio a um ambiente galáctico turbulento e dinâmico? De onde vieram os elementos que compõem nosso planeta e a nós mesmos? Graças a esta fusão revolucionária de simulação e inteligência artificial, estamos mais perto do que nunca de encontrar as respostas. Estamos no limiar de uma nova era de descobertas, onde o universo digital dentro de nossos supercomputadores se torna um espelho cada vez mais fiel do universo real que nos rodeia.

1. O que torna esta simulação da Via Láctea tão revolucionária?

Esta é a primeira simulação que acompanha a evolução de cada estrela individualmente na Via Láctea, utilizando 49 bilhões de partículas. O grande diferencial é a combinação inovadora de simulações hidrodinâmicas tradicionais com um modelo de inteligência artificial baseado em deep learning. Isso permitiu quebrar a chamada “barreira de um bilhão de partículas” que limitava as simulações anteriores. Além disso, o método é mais de 100 vezes mais rápido que as técnicas convencionais, permitindo simular 1 milhão de anos da evolução galáctica em menos de 3 horas no supercomputador Fugaku.

2. Como a inteligência artificial foi utilizada nesta simulação?

A inteligência artificial atua como um “modelo substituto” para resolver o problema mais difícil da simulação: as explosões de supernovas. Quando uma estrela massiva explode, a IA (baseada em uma rede neural convolucional 3D chamada U-Net) prevê como a explosão evoluirá e afetará o gás circundante, sem precisar calcular cada detalhe manualmente. O modelo foi treinado com milhares de simulações de supernovas de alta resolução e consegue prever com precisão a evolução da explosão ao longo de 100.000 anos. Isso elimina a necessidade de usar passos de tempo extremamente pequenos, que tornavam as simulações anteriores proibitivamente lentas.

3. Quantas partículas foram utilizadas e o que cada uma representa?

A simulação utilizou um total de 49 bilhões de partículas, distribuídas da seguinte forma: 180 bilhões de partículas de matéria escura, 72 bilhões de partículas estelares e 49 bilhões de partículas de gás. Cada partícula de estrela tem uma massa de apenas 0,75 massas solares, e cada partícula de gás também tem 0,75 massas solares. As partículas de matéria escura têm 6 massas solares cada. Essa resolução sem precedentes permite que os cientistas acompanhem a formação e evolução de estrelas individuais, algo impossível nas simulações anteriores que tratavam grupos inteiros de estrelas como uma única partícula.

4. Qual supercomputador foi usado e qual sua capacidade?

O supercomputador principal utilizado foi o Fugaku, localizado no Japão, considerado um dos mais poderosos do mundo. A simulação utilizou 148.896 nós computacionais (95% de todo o sistema Fugaku), equivalente a 7.147.200 núcleos de CPU. Cada nó possui um processador Fujitsu A64FX com 48 núcleos e 32 GB de memória. A performance teórica de pico é de 6,144 teraflops por nó em precisão simples. Os pesquisadores também testaram o código em outros sistemas, incluindo o cluster Rusty (com processadores AMD EPYC) e o sistema Miyabi (com GPUs NVIDIA H100), demonstrando que o método funciona em diversas arquiteturas.

5. Quanto tempo levou para realizar a simulação completa?

Com o passo de tempo fixo de 2.000 anos adotado pela nova metodologia, simular 1 milhão de anos da evolução da Via Láctea requer 500 passos computacionais. Usando 148.896 nós do supercomputador Fugaku, o tempo de solução foi de apenas 10.000 segundos, ou aproximadamente 2,78 horas, para 1 milhão de anos. Para simular 10 milhões de anos da evolução galáctica, o tempo estimado é de cerca de 28 horas. Isso representa um avanço extraordinário: simulações convencionais com passo de tempo adaptativo levariam mais de 100 vezes esse tempo para alcançar a mesma resolução.

6. O que é a “barreira de um bilhão de partículas” e como foi superada?

A “barreira de um bilhão de partículas” é uma limitação computacional que impedia as simulações galácticas de usar mais de um bilhão de partículas devido ao tempo de processamento proibitivo. O problema surge porque fenômenos de pequena escala, como explosões de supernovas, exigem passos de tempo extremamente curtos (cerca de 100 anos), enquanto a galáxia evolui ao longo de bilhões de anos. A solução desenvolvida pela equipe foi dividir o trabalho: os “nós principais” simulam a galáxia com passos de tempo grandes (2.000 anos), enquanto “nós de pool” usam IA para prever rapidamente a evolução das supernovas. Isso permitiu usar 49 bilhões de partículas, quebrando definitivamente essa barreira.

7. Quais descobertas científicas podem ser feitas com esta simulação?

Esta simulação abre portas para diversas descobertas científicas fundamentais. Os pesquisadores podem estudar a “arqueologia galáctica”, comparando a composição química das estrelas simuladas com estrelas reais para entender como elementos pesados foram produzidos e distribuídos ao longo do tempo. É possível investigar o ciclo completo de vida da matéria, desde o gás interestelar até a formação de estrelas e o retorno de material via supernovas. A simulação também permite estudar a formação de estruturas estelares como aglomerados, a turbulência do gás interestelar e a regulação da taxa de formação estelar. Além disso, ajuda a entender como nossa própria galáxia evoluiu para sua forma atual.

8. Como a simulação lida com as explosões de supernovas?

Quando uma estrela massiva está prestes a explodir como supernova, a simulação isola uma região cúbica de 60 parsecs (cerca de 195 anos-luz) ao redor da estrela. Todas as partículas dentro deste cubo são enviadas para um conjunto separado de processadores chamados “nós de pool”. Esses nós utilizam um modelo de rede neural U-Net pré-treinado que prevê como a explosão evoluirá com base nas condições iniciais do gás (densidade, temperatura e velocidade). O modelo foi treinado com milhares de simulações detalhadas de supernovas e consegue prever com precisão a distribuição de gás, temperatura e velocidade após 100.000 anos. O resultado é então enviado de volta para a simulação principal, que continua sua evolução.

9. Qual a precisão desta simulação comparada à Via Láctea real?

A simulação foi calibrada para reproduzir as características observadas da Via Láctea real. O modelo inicial foi gerado usando a arquitetura AGAMA (Action-based Galaxy Modelling Architecture), com uma massa total de 1,1 trilhão de massas solares de matéria escura, 54 bilhões de massas solares de estrelas e 12 bilhões de massas solares de gás – valores consistentes com as estimativas da Via Láctea real. A resolução de massa (0,75 massas solares por partícula estelar) é suficiente para resolver estrelas individuais. O modelo de IA foi validado através de comparação direta com simulações numéricas convencionais, demonstrando que reproduz corretamente as funções de distribuição de densidade e temperatura do gás. Esta é a simulação mais realista já criada de uma galáxia do tamanho da Via Láctea.

10. Esta técnica pode ser aplicada a outras áreas da ciência?

Sim, absolutamente. A metodologia híbrida que combina simulações baseadas em primeiros princípios com modelos de inteligência artificial representa um novo paradigma aplicável a qualquer campo científico que lide com fenômenos que abrangem múltiplas escalas espaciais e temporais. Na astrofísica, a técnica pode ser estendida para simular a formação de buracos negros supermassivos, interações entre galáxias em colisão, ou a evolução de aglomerados de galáxias. Fora da astronomia, campos como ciência dos materiais, climatologia, oceanografia, dinâmica de fluidos e até mesmo biologia molecular podem se beneficiar. Qualquer problema onde pequenos eventos locais (como reações químicas ou turbulência) afetam a evolução de sistemas grandes pode usar abordagens semelhantes para acelerar dramaticamente as simulações.

Referências